بودجه کراول، تعداد صفحاتی از یک سایت است که رباتهای گوگل در طی یک بازه زمانی مشخص (مثلا در یک شبانه روز) بررسی میکنند و اصطلاحا آنها را خزش یا کراول (Crawl) میکنند. اگر صفحات جدید سایتمان خزیده نشوند، ایندکس (index) هم نمیشوند و این یعنی خبری از نمایش در نتایج موتور جستجو گوگل نیست! بنابراین توجه به بودجه خزش یا Crawl budget از اهمیت ویژهای در سئو سایتها برخوردار است.

بودجه خزش (Crawl Budget) چیست؟

مهمترین هدف گوگل، رساندن بهترین و جدیدترین محتواها به دست کاربران است. رباتهای گوگل دائما در حال چرخیدن در سایتهای مختلف هستند تا بهترین و جدیدترین محتواها را پیدا کنند و در اختیار کاربران قرار دهند. این رباتها برای پیدا کردن صفحات جدید و تغییرات به وجود آمده در صفحات قدیمیتر به سایتها مراجعه میکنند و به اصطلاح آنها خزش یا Crawl میکنند.

اما تمام سایتها به یک میزان و یک نرخ ثابت خزیده نمیشوند و رباتهای گوگل به تغییراتی که در برخی سایتها به وجود میآیند حساستر هستند و سریعتر متوجه تغییرات این صفحات میشوند.

با این تفاسیر، وبمستران مفهومی به نام بودجه خزش یا Crawl Budget را تعریف کردند تا مشخص کنند میزان توجه رباتهای گوگل به سایتهای مختلف چقدر است.

در یک تعریف ساده میتوان Crawl Budget را اینگونه تعریف کرد:

تعداد دفعاتی که رباتهای گوگل در طول یک بازه زمانی مشخص (مثلا یک شبانه روز) به صفحات یک سایت سر میزنند و تغییرات آنها را بررسی میکنند.

با این تعریف حتما متوجه شدهاید که ممکن است برخی از صفحات در طول یک شبانه روز چندین بار خزیده شوند و برخی صفحات در طول یک شبانه روز حتی یکبار هم خزیده نشوند و بازه خزش طولانی مدتتری داشته باشند.

در ادامه این مقاله قصد داریم که به طور مفصل به تمام جوانب بودجه خزش و پارامترهای تاثیرگذار بر آن و روشهای بهینه سازی و افزایش آن بپردازیم.

چرا گوگل نرخ خزش مشخصی را به هر سایت اختصاص میدهد؟

موتورهای جستجو، منابع پردازشی نامحدودی را در اختیار ندارند و در دنیای اینترنت هم بیشتر از چندین میلیون وبسایت مختلف حضور دارند که موتورهای جستجو باید محتوای آنها را بررسی کنند.

گوگل هم به عنوان مهمترین موتور جستجو از این قاعده مستثنی نیست، به همین خاطر مجبور است که با توجه به فاکتورهای مشخصی، توان پردازشی محدود خود را برای جستجو در محتوای سایتهای مختلف تقسیم کند و به هر سایت یک بودجه مشخصی را اختصاص دهد.

به همین خاطر گوگل مجبور است که به هر سایت، یک نرخ کراول مشخصی را اختصاص دهد.

اهمیت کراول باجت در سئو سایتها

اگرچه گوگل صراحتا اعلام کرده که crawl budget جزو پارامترهای سئو و رتبه بندی سایتها نیست اما مشکلات بودجه خزش میتواند دردسرهای مختلفی را برای محتواهای ما به وجود بیاورد.

به طور خیلی خلاصه، اگر شما بهترین محتوای دنیا را هم تولید کنید اما توسط رباتهای گوگل ایندکس و بررسی نشود، در حقیقت محتوایی برای رقابت در نتایج گوگل ندارید!

به همین خاطر هدر دادن بودجه خزش و پایین بودن آن میتواند عملکرد سایت در سئو را تا حد چشمگیری کاهش دهد.

در ادامه به مهمترین دلایل اهمیت بودجه کراول در سئو سایتها میپردازیم.

ایندکس محتواها

همانطور که گفتیم، ایندکس شدن محتواهای جدید و اطلاع گوگل از آخرین تغییرات سایت ما مستلزم مراجعه رباتهای گوگل به صفحات سایت ما و خزش آنهاست.

بنابراین مشکلات خیلی شدید در بودجه خزش حتی میتواند باعث نادیده گرفتن شدن برخی از محتواهای ما توسط موتور جستجو گوگل شود و بهبودهای ما در سئو سایت هم دیده نشوند و مثمر ثمر واقع نشوند.

دزدیده شدن محتوا

بسیاری از سایتهای بزرگ و محتوا محور با مشکلی به نام دزدی محتوا رو به رو هستند.

بسیاری از سایتها به کمک رباتهای خبرخوانی که دارند، جدیدترین محتواها و اخبار روز دنیا را جمع آوری میکنند و به سرعت در وبسایت خود منتشر میکنند.

اگر سرعت ایندکس شدن سایت شما در مقابل با یک سایت سارق که عینا محتواهای شما را کپی میکند و در سایت خود قرار میدهد کمتر باشد، ممکن است محتواهای اورجینالی که توسط شما منتشر شدهاند برای اولین بار توسط رباتهای گوگل در سایت سارق و رقیبتان دیده شوند و به نام سایت سارق و رقیب شما ثبت شوند.

به این ترتیب به خاطر مشکلات بودجه خزش، شما به عنوان کپی کننده محتوا و سارق، در چشم گوگل دیده شوید!

استفاده از ترندها و دریافت بازدیدهای انفجاری

برخی از اتفاقات هستند که به سرعت در بین عموم جامعه به یک جریان و ترند تبدیل میشوند و در دنیای دیجیتال مارکتینگ استفاده از این ترندها و اتفاقات یکی از کارهای مرسوم برای جذب مخاطبان و همراه شدن با جریانات جامعه است.

دقیقا در سئو سایت و جذب ترافیک اورگانیک هم ما میتوانیم به کمک این ترندها در مقاطع زمانی کوتاهی بازدید و ترافیک خیلی زیادی به دست آوریم.

کافیست اولین نفری باشید که درباره موضوعات داغ جامعه محتوا تولید میکنید تا به سرعت به نتیجه اول گوگل برسید و ترافیک فوق العادهای بدست آورید.

اما اگر سایت شما مشکلات جدی در بودجه خزش خود داشته باشد و محتواهای جدید شما بعد از گذشت چندین روز ایندکس شوند به راحتی این فرصتهای استثنایی را از دست خواهید داد.

آیا تمام سایتها باید نگران اندازه Crawl Budget خودشان باشند؟

گوگل در خزیدن سایتها واقعا متبحر است و بارها اعلام کرده که هیچ دلیلی برای نگرانی سایتهای مختلف در مورد بودجه خزش وجود ندارد و Crawl budget تنها در سایتهای بزرگی که صفحات آنها در بازههای زمانی کوتاهی بروزرسانی و آپدیت میشوند میتواند مشکل ساز شود.

با این حال گوگل صراحتا اعلام کرده که تنها اگر جزو دو دسته زیر هستید باید برای بهینه سازی Crawl budget خود دست به کار شوید:

- سایتهای خیلی بزرگ (بیش از یک میلیون صفحه) که محتواهای آنها تقریبا هر هفته بروز رسانی میشود

- سایتهای متوسط و بزرگ (بیش از 10 هزار صفحه) که محتواهای آنها تقریبا هر روز در حال آپدیت است

اما گاها در سایتهای متوسط و کوچکی که از ساختار مناسبی برخوردار نیستند هم مشکلاتی از ناحیه ایندکس شدن و کراول شدن صفحات جدید به وجود میآید که باید برای بررسی و رفع مشکلات اقدام کرد.

چطور بفهمیم سایتمان مشکل Crawl budget دارد؟

همانطور که فهمیدید بیشتر سایتها نباید نگرانی در مورد بودجه خزیدن سایت خودشان داشته باشند.

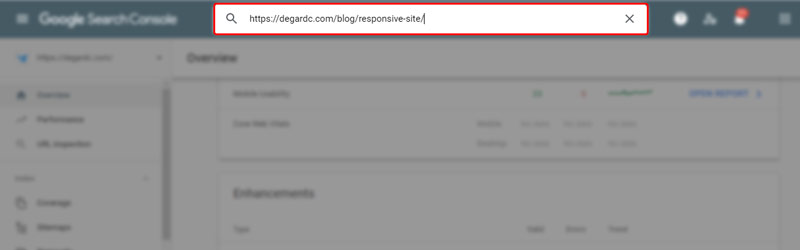

اما یک راه حل ساده برای فهمیدن مشکل بودجه خزش در سایت، استفاده از ابزار URL Inspection tool گوگل سرچ کنسول است. این ابزار به ما کمک میکند تا متوجه مشکلاتی شویم که از ایندکس شدن یک صفحه جلوگیری میکنند و همینطور بفهمیم که آیا صفحه مورد نظر ما به ایندکس گوگل اضافه شده است یا خیر.

به این ترتیب میتوانیم متوجه شویم که وقتی محتوای جدیدی را به سایتمان اضافه میکنیم، آیا به سرعت توسط رباتهای گوگل خزیده میشود و یا چندین روز طول میکشد تا رباتهای گوگل متوجه اضافه شدن آن شوند.

برای این کار کافیست تا وارد اکانت گوگل سرچ کنسول وبسایت خودمان شویم و از قسمت URL Inspection

آدرس صفحه مورد نظرمان که به تازگی آن را منتشر کردیم وارد کنیم تا از آخرین وضعیت آن باخبر شویم.

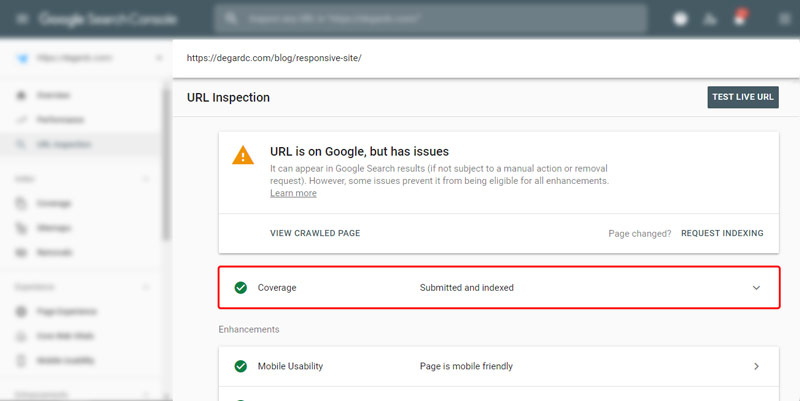

بعد از چند ثانیه، گوگل اطلاعاتی در مورد این صفحه و وضعیت ایندکس این URL به ما میدهد.

در این صفحه ما با توجه به وضعیت صفحه، سه حالت سبز، نارنجی و قرمز را مشاهده خواهیم کرد.

وضعیت سبز به معنی بدون مشکل بودن صفحه از جنبههای مختلف است و همینطور نشان میدهد که صفحه مشکلی از بابت ایندکس شدن ندارد.

وضعیت نارنجی به معنی وجود برخی مشکلات در صفحه است (مانند موبایل فرندلی نبودن صفحه) که باید برطرف شوند، اما این وضعیت هم مشکلی برای ایندکس صفحه ایجاد نمیکند.

اما وضعیت قرمز به معنی وجود مشکلی در صفحه است که از ایندکس شدن صفحه جلوگیری میکند. به عنوان مثال ممکن است سرورهای گوگل دسترسی به این صفحه نداشته باشند، DNS سایت به درستی تنظیم نشده باشد، ریدایرکتهای صفحه مشکل ساز شده باشند و خیلی از مشکلات دیگری که میتوانند از ایندکس شدن این صفحه جلوگیری کنند.

با تمام این توضیحات، اگر محتواهای جدیدی که به وبسایتتان اضافه میکنید را در بخش URL Inspection tool بررسی کردید و متوجه شدید که خطایی برای ایندکس شدن و خزش صفحه وجود ندارد (وضعیت سبز یا نارنجی) اما همچنان بعد از گذشت 24 ساعت، هنوز در بخش Coverage به صورت ایندکس نشده نمایش داده میشوند، میتوان به مشکل کراول باجت شک کرد.

Crawl Budget به چه عواملی بستگی دارد و چگونه تعیین میشود؟

گوگل صراحتا اعلام کرده که بودجه خزش برابر با تعداد URLهایی است که رباتهای گوگل میتوانند و میخواهند بررسی کنند.

توانایی رباتهای گوگل برای خزش صفحات یک سایت تحت تاثیر فاکتوری به نام Crawl Limit Rate است و خواستن رباتهای گوگل برای خزش صفحات یک سایت به پارامتری به نام Crawl Demand بستگی دارد.

اما این دو مفهوم دقیقا به چه معنایی هستند و خودشان به چه عواملی بستگی دارند؟

محدودیت نرخ خزش یا Crawl Limit Rate چیست؟

دقیقا مشابه موتورهای جستجو که منابع محدودی برای خزیدن و جستجو در دنیای اینترنت دارند، وبسایتها هم منابع محدودی در اختیار دارند و وقتی تعداد افرادی که همزمان از یک وبسایت بازدید میکنند از یک حدی فراتر میرود، سایت اصطلاحا down میشود و دیگر قادر به سرویسدهی نیست.

خزیدن در سایتها هم برای رباتهای گوگل اولویت شماره یک است، اما به شرطی که این خزش موجب لطمه زدن به تجربه کاربری کاربران واقعی در سایت و down شدن سایت نشود.

به همین خاطر رباتهای گوگل با توجه به منابعی که هر سایت در اختیار دارد و همچنین مدت زمان انتظاری که بین هر کراول باید منتظر پاسخ از سمت وبسایت بمانند، یک محدودیت مشخص در تعداد دفعات کراول خود در نظر میگیرند.

به این محدودیت، Crawl Rate Limit یا محدودیت نرخ خزش گفته میشود.

محدودیت نرخ خزش به چه عواملی بستگی دارد؟

به طور کلی رباتهای گوگل با توجه به دو فاکتور زیر Crawl Rate Limit سایتها را مشخص میکنند:

سلامت خزش یا Crawl Health: اگر وبسایت برای مدت زمان مشخصی به درخواستها به سرعت پاسخ بدهد، نرخ خزش افزایش پیدا میکند، اما اگر رباتهای گوگل هنگام خزیدن سایت با خطاهای مختلف سرور و کاهش سرعت سایت مواجه شوند به این نتیجه میرسند که نرخ خزش فعلی باید کاهش پیدا کند و سایت هنوز از زیرساخت مناسبی برخوردار نیست.

محدودیت تعریف شده در گوگل سرچ کنسول: صاحبان وبسایتها هم میتوانند با توجه به شناختی که از منابع سخت افزاری وبسایت خود دارند درخواست کاهش یا افزایش نرخ خزش وبسایتشان را به گوگل بدهند، هرچند که گوگل صراحتا اعلام کرده که کاهش نرخ کراول را مستقیما در نظر میگیرد اما هیچ تضمینی نیست که به افزایش آن اهمیت بدهد.

تقاضا برای خزش یا Crawl Demand چیست؟

دیدیم که هر سایتی با توجه به منابع سخت افزاری که در اختیار دارد میتواند تا یک محدودیت نرخ خزش مشخصی را پاسخ دهد، اما خیلی اوقات پیش میآید که رباتهای گوگل احساس میکنند یک سایت نیازی به کراول شدن و بررسی مجدد ندارد و به این ترتیب با وجود اینکه هنوز تا محدودیت نرخ خزش سایت فاصله زیادی است اما رباتهای گوگل برای خزیدن به سایت سر نمیزنند.

در این حالت تقاضا خزش یا Crawl Demand پایینی وجود دارد.

Crawl Demand به چه فاکتورهایی بستگی دارد؟

میتوان سه فاکتور زیر را عوامل اصلی تعیین Crawl Demand سایتها در نظر گرفت:

فهرست صفحات پیدا شده یا Perceived inventory: اگر ما رباتهای گوگل را در مورد خزیدن سایتمان راهنمایی نکنیم، سعی میکنند تمام URLهایی که از سایت ما پیدا میکنند را بخزند. در صورتی که ممکن است خیلی از این صفحات به دلایلی (تکراری بودن، حذف شدن، بی اهمیت بودن و …) نیاز به خزیدن نداشته باشند. وجود همین صفحات در سایت، باعث اتلاف وقت رباتهای خزشگر گوگل و به دنبال آن کاهش نیاز به خزش سایت میشود.

محبوبیت یا Popularity: محبوبیت یک صفحه در اینترنت با تعداد لینکهایی ورودی به آن صفحه تعریف میشود. به همین ترتیب صفحاتی که لینکهای داخلی و خارجی بیشتری دارند از محبوبیت بیشتری برخوردارند و رباتهای گوگل هم سعی میکنند تا با فرکانس بیشتری به آنها سر بزنند تا در جریان آخرین تغییرات این صفحات قرار بگیرند.

راکد بودن یا Staleness: راکد بودن یک صفحه در اینترنت به این معنی است که چه مدت زمانی از آخرین تغییر در آن صفحه میگذرد. صفحاتی که دائما در حال بروزرسانی و تغییرات هستند، صفحات زندهتری هستند و رباتهای گوگل هم علاقه دارند تا در جریان آخرین تغییرات اینگونه صفحات قرار بگیرند. علاوه بر تقاضا خزش بالاتر این گونه صفحات، الگوریتمهای گوگل مثل الگوریتم تازگی محتوا هم علاقه زیادی به اینگونه صفحات دارند.

علاوه بر این، تغییرات گسترده در سطح وبسایت (مانند عوض کردن دامنه سایت) هم میتوانند به صورت موقتی میزان تقاضا برای خزش را تا حد محدودیت نرخ خزش بالا ببرند تا به این ترتیب محتواها تحت URLهای جدید مجددا index شوند.

چطور بودجه خزش سایتمان را افزایش دهیم و بهینه کنیم؟

حالا که کاملا با بودجه کراول و پارامترهایی تاثیر گذار بر آن آشنا شدیم، باید به بررسی این نکته بپردازیم که چطور میتوانیم بودجه خزش سایتمان را افزایش دهیم و یا چطور از همان بودجهای فعلیمان بهتر و بهینهتر استفاده کنیم.

مواظب محتواهای تکراری سایتتان باشید

محتواهای تکراری، صفحاتی از سایتتان هستند که URLهای متفاوت اما محتواهای یکسانی دارند. به عنوان مثال اگر یک محتوای یکسان را در دو صفحه A و B عینا تکرار کنید، یک محتوای تکراری ایجاد کردهاید اما در بیشتر مواقع این محتواهای تکراری بدون آگاهی ما و بخاطر مشکلات برنامه نویسی ایجاد میشوند.

اگر تصور میکنید که سایتتان محتوای تکراری ندارد، بد نیست که بدانید در مطالعهای که در بین سالهای 2013 تا 2015 انجام شد اینطور مشخص شد که چیزی در حدود 30 درصد از محتواهای موجود در اینترنت تکراری هستند!

وجود تعداد زیادی محتوای تکراری در سایت، باعث میشود که زمان و هزینهای که رباتهای گوگل برای خزیدن صفحات سایت شما در نظر گرفتهاند صرف خزیدن محتواهایی شود که هیچ فایدهای برای شما ندارند.

محتواهای تکراری علاوه بر اینکه بودجه خزش و تمایل رباتهای گوگل به خزیدن سایت را کاهش میدهند مشکلات متعدد دیگری نیز برای سئو سایت شما به وجود میآورند. توصیه میکنیم حتما مقاله “duplicate content چیست” را با دقت مطالعه کنید تا با جوانب مختلف تاثیر محتواهای تکراری بر روی سئو سایتها آشنا شوید.

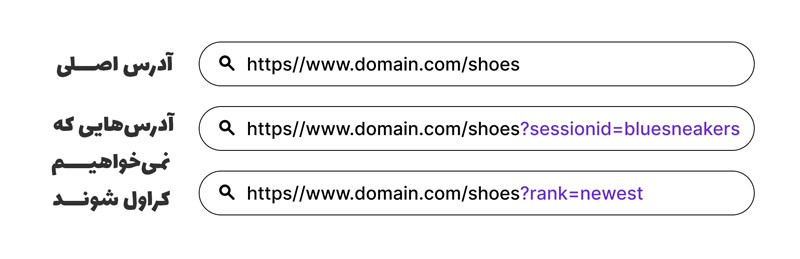

دسترسی رباتهای گوگل به صفحاتی که نیازی به نمایش در نتایج جستجو ندارند را ببندید

ممکن است برخی صفحات برای کاربران از اهمیت ویژهای برخوردار باشند اما علاقه به نمایش آنها در نتایج گوگل نداشته باشیم.

به عنوان مثال صفحات لیست محصولات فروشگاهها و فیلترهایی که در این صفحات میتوان اعمال کرد باعث ایجاد صفحات تکراری با URLهای مختلف میشوند، اما بخاطر رفاه کاربران مجبوریم که از آنها استفاده کنیم.

در این حالت به کمک ابزار URL Parameter Tools گوگل و یا به کمک فایل robots.txt میتوانیم به رباتهای گوگل اعلام کنیم که این صفحات را بررسی و خزش نکنند.

تذکر: برای مسدود کردن دسترسی رباتهای گوگل به صفحات از تگ noindex استفاده نکنید، چرا که رباتهای گوگل بعد از دیدن این تگ از کراول کردن صفحه صرف نظر میکنند و همین مدت زمان میتواند باعث هدر رفتن زمان ارزشمند رباتهای گوگل شود!

از کدهای وضعیت 404/410 برای صفحاتی که به طور کامل پاک شدهاند استفاده کنید

رباتهای گوگل معمولا به سختی URLهایی که قبلا آنها را دیدهاند فراموش میکنند، اما کدهای وضعیت 404 و 410 یک سیگنال قوی به رباتهای گوگل میدهند مبنی بر اینکه دیگر قرار نیست از این URLها استفاده شود.

به همین خاطر بجای بلاک کردن دسترسی رباتهای گوگل به صفحاتی که مطمئن هستید برای همیشه پاک شدهاند، از کدهای وضعیت 404 و 410 استفاده کنید.

از soft 404 استفاده نکنید

خطای soft 404 به این معنی است که شما در حال نشان دادن صفحهای به کاربر هستید که وجود ندارد و عملا یک صفحه 404 است، اما HTTP status code مربوط به این صفحه، کد 200 است.

به همین خاطر رباتهای گوگل ممکن است تمام این صفحات به ظاهر 404 را ایندکس و محتواهای ضعیف و تکراری در نظر بگیرند!

برای جلوگیری از این مشکل، حتما مطمئن شوید که صفحات 404 شما کد وضعیت 404 را هم برمیگردانند.

نقشه سایتتان را بروز نگه دارید

رباتهای گوگل برای خزیدن صفحات مختلف سایت شما از نقشه سایت شما کمک میگیرند. بروز نگه داشتن نقشه سایت و طراحی مناسب آن میتواند در هدایت کردن یا گمراه کردن رباتهای گوگل نقش به سزایی را بازی کند.

همیشه توصیه میشود که محتوای نقشه سایتتان و اینکه چه صفحاتی در آن حضور دارند را به صورت منظم بررسی کنید.

اگر اطلاعاتی راجع به نقشه سایت و اینکه چطور یک نقشه سایت بهینه و استاندارد برای سایتمان ایجاد کنیم ندارید، توصیه میکنیم که حتما مقاله “نقشه سایت چیست” را با دقت مطالعه کنید.

از زنجیرهای ریدایرکت طولانی خودداری کنید

ریدایرکتهای طولانی و چند مرحلهای هم باعث اتلاف وقت رباتهای گوگل میشوند.

هرچند که استفاده از ریدایرکت در بسیاری از اوقات تنها راه حل ممکن و گاها بهترین راه حل ممکن است، اما استفاده گسترده و در حجم بالا از ریدایرکت هم مناسب نیست و همانطور که گفتیم باعث اتلاف وقت رباتهای گوگل و کاهش سرعت سایت شما میشوند.

سرعت سایتتان را افزایش دهید

سرعت سایت از جمله پارامترهایی است که تاثیر مستقیم و زیادی بر روی بهینه خرج شدن بودجه خزش و صرفه جویی در زمان رباتهای گوگل ایجاد میکند.

با افزایش سرعت سایت، خزندههای گوگل زمان کمتری برای بررسی هر صفحه صرف میکنند و به این ترتیب میتوانند صفحات خیلی بیشتری از سایت را بررسی کنند.

دقیقا برعکس همین موضوع برای صفحات کند هم وجود دارد، صفحاتی که سرعت لود پایینی دارند باعث اتلاف وقت رباتهای گوگل و کاهش تعداد صفحاتی میشوند که کراولرهای گوگل میتوانند در یک زمان ثابت بررسی کنند.

اعتبار صفحات سایتتان را به کمک لینکسازی اقزایش دهید

همانطور که گفتیم صفحات محبوب و معتبر از اهمیت ویژهای پیش گوگل برخوردار هستند و هرچه اعتبار صفحات سایت شما بیشتر باشند گوگل هم به ناچار مجبور است تا به تعداد دفعات بیشتری به سایت شما سر بزند.

اما فراموش نکنید که لینکسازی مثل یک شمشیر دولبه و تیز است که میتواند به راحتی توسط الگوریتمهای گوگل مثل الگوریتم پنگوئن گوگل شناسایی و مجازات شود.

از هاست باکیفیت و یا سرورهای اختصاصی و مجازی استفاده کنید

علاوه بر سرعت سایت، پایداری سایت و بالا بودن سایت هم از جمله پارامترهای خیلی مهم و حساسی است که رباتهای گوگل برای تعیین بودجه خزش سایتها در نظر میگیرند.

سایتی را در نظر بگیرید که با کمی افزایش ترافیک down میشود و از دسترس خارج میشود. در این حالت وقتی رباتهای گوگل به این سایت میرسند بخاطر ضعیف بودن زیرساختهای سایت، سعی میکنند دفعات کمتری به سایت مراجعه کنند تا مشکلی به مشکلات سایت اضافه نکنند و سایت بیشتر از این که هست از دسترس خارج نشود.

همین موضوع در طولانی مدت باعث کاهش چشمگیر محدودیتهای نرخ خزش سایت و به دنبال آن کاهش کلی بودجه خزش سایت میشود.

وضعیت کراول شدن سایتتان را هرچند وقت یکبار بررسی کنید

بررسی وضعیت ایندکس و کراول سایت یکی از کارهایی است که به صورت منظم و هر چند وقت یکبار باید انجام شود تا هرچه زودتر از هرگونه مشکلات احتمالی باخبر شوید.

وجود مشکلات در سرور و هاست، هک شدن سایت، وجود مشکلات در فایل robots.txt و سایت مپ و سایر مسائل، در طولانی مدت تاثیر خودشان را بر روی وضعیت کراول شدن سایت نشان میدهند و برای درمان مشکلات پیش آمده در مرحله اول باید در جریان این مشکلات قرار گرفت.

چک کردن وضعیت خزش سایت کمک زیادی در تشخیص مشکلات مهم اما پنهان سایت میکند.

جمع بندی نهایی

در این مقاله به طور کامل به تمام مسائل مربوط به crawl budget پرداختیم و دیدیم که بیشتر سایتها نباید نگرانی در مورد بودجه خزش خودشان داشته باشند و بیشتر سایتهای بزرگ و یا سایتهایی که دائما در حال بروزرسانی هستند مانند سایتهای فروشگاهی بزرگ یا سایتهای خبری بزرگ، باید مواظب مشکلات crawl budget سایت خودشان باشند.

بودجه خزش اگرچه تاثیر مستقیمی بر روی سئو سایتها ندارد اما یک بودجه خزش همراه با مشکل، میتواند تمام تلاشهای صادقانه شما را از بین ببرد و بیتاثیر کند.

در پایان مثل همیشه اگر درباره موضوع نرخ خزش و مسائل و مشکلات مرتبط با آن، ابهام و یا سوالی در ذهنتان دارید، در بخش نظرات با ما درمیان بگذارید تا کارشناسان دگردیسی در کمتر از 24 ساعت به پرسشهای شما پاسخ دهند.

مشتاقانه از تجربیات و نظرات شما استقبال خواهیم کرد.